人工智能基礎軟件開發 當單純的AI遇見復雜的人性

在技術飛速發展的今天,“人工智能很單純,復雜的是人”這句話常常被提及,它精準地捕捉了AI技術開發與應用中的核心悖論。人工智能的基礎軟件開發,正是在這種張力中不斷演進的領域。它一方面追求算法的純粹、邏輯的嚴謹與效率的極致;另一方面,又無可避免地被人類的意圖、偏見、倫理困境和社會需求所塑造和復雜化。

一、AI的“單純”:源于確定性的根基

人工智能,尤其是其底層軟件與算法,本質上是數學與邏輯的產物。它的“單純”體現在幾個方面:

- 目標明確:無論是圖像識別、自然語言處理還是決策推薦,AI模型在訓練階段的目標函數通常是清晰、可量化的(如準確率、損失函數最小值)。它純粹地向著優化這個目標前進。

- 規則驅動:其行為完全由代碼、數據和訓練所得的參數決定,沒有主觀意識、情感波動或隱秘動機。給它相同的輸入,在相同環境下,理論上會得到穩定可復現的輸出。

- 無道德直覺:AI本身沒有善惡觀念。它無法理解其預測或決策可能蘊含的倫理意義,除非這種考量被開發者 explicitly(明確地)設計進目標或約束中。

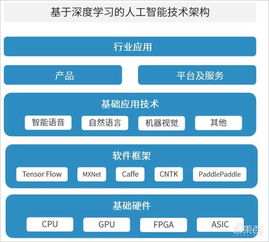

基礎軟件開發的核心任務,如框架設計(TensorFlow, PyTorch)、算法實現、算力優化和系統集成,正是為了構建和支撐這種高效、穩定且可擴展的“單純”能力。開發者如同在打造一件精密樂器,追求的是響應準確、音色純凈。

二、人的“復雜”:注入價值與偏見的源頭

這件“樂器”演奏什么曲子、如何演奏,以及演奏的效果,卻完全掌握在復雜的人類手中。人的復雜性深刻滲透于AI基礎軟件開發的各個環節:

- 數據之鏡:AI通過學習數據來認知世界。而訓練數據由人類產生和選擇,不可避免地反映了人類社會現有的偏見、不平等和歷史遺留問題。基礎軟件工具雖然提供了數據處理管道,但選擇收集哪些數據、如何標注數據,卻充滿主觀判斷和價值取向。

- 目標設定之重:開發者決定AI優化什么目標。是單純追求點擊率最大化,還是在推薦算法中融入多樣性、公平性?這個看似技術性的選擇,實質上是價值判斷。一個“單純”追求利潤最大化的算法,可能導致信息繭房或歧視性定價。

- 應用場景之變:同樣的圖像識別技術,可用于醫療診斷挽救生命,也可用于大規模監控侵蝕隱私。基礎軟件提供了能力,但其部署和使用的意圖,取決于組織與個人的決策,涉及復雜的法律、倫理和利益權衡。

- 解釋與問責之困:即便開發出性能卓越的模型,其“黑箱”特性常使決策過程難以解釋。當AI做出錯誤或有爭議的判斷時,責任應由“單純”的算法承擔,還是背后“復雜”的設計者、部署者或監管者承擔?這迫使基礎軟件開發也開始融入可解釋性(XAI)工具。

三、基礎軟件開發的演進:在單純與復雜間架橋

因此,現代人工智能基礎軟件開發已超越純技術范疇,正在積極回應人性的復雜。其新趨勢包括:

- 責任AI工具包集成:在開發框架中,逐漸融入公平性檢測、偏見緩解、模型可解釋性、數據溯源等工具,幫助開發者更早地察覺和應對倫理風險。

- 安全與魯棒性優先:不僅防范傳統軟件漏洞,更專注于研究對抗性攻擊的防御,確保AI系統在面對惡意輸入時行為穩定可靠,避免被“復雜”的惡意利用。

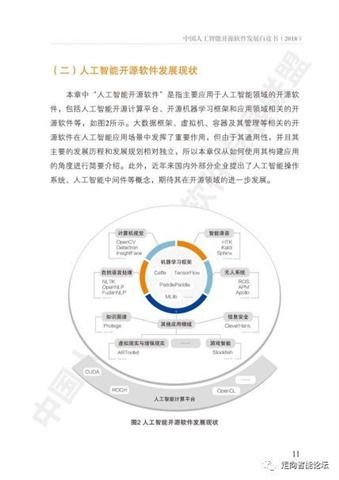

- 開源與協作倫理:通過開源社區推動透明、共享的開發模式,讓更多元的視角參與進來,共同審視和規范基礎技術的方向,避免技術被少數利益集團壟斷而加劇社會不公。

- 從“性能至上”到“價值對齊”:開發范式正在從一味追求更高的準確率、更低的延遲,轉向思考如何讓AI系統的目標與人類整體價值觀、長期福祉相“對齊”。這要求基礎軟件提供更靈活的約束設計和價值函數建模能力。

###

人工智能基礎軟件開發,是一場在硅基的“單純”與碳基的“復雜”之間進行的持續對話。我們打造的不僅是一套高效的計算工具,更是一個將人類智慧、價值觀和責任感嵌入技術基座的接口。未來的方向,不是讓AI變得像人一樣復雜難測,而是通過更審慎、更包容、更負責任的基礎軟件開發,讓這項強大的“單純”技術,能夠在復雜的人類社會中,穩健、公平且有益地運行。讓技術之光照亮的是人性的良善,而非其陰影。

如若轉載,請注明出處:http://www.regant.cn/product/45.html

更新時間:2026-01-07 03:11:57